Halo, Sobat Jagoan! Secara bawaan, Ollama jalan lewat command-line interface (CLI). Tapi kalau kamu nggak mau ribet dengan perintah terminal, kamu bisa pakai Open WebUI. Dengan ini, Ollama jadi punya tampilan mirip ChatGPT, jadi lebih gampang dipakai, terutama kalau kamu lebih suka visual dibanding mengetik perintah manual.

Di panduan ini, kamu akan belajar cara men-deploy Ollama dan Open WebUI di VPS Ubuntu 24.04 menggunakan Docker Compose. Setup ini memungkinkan kamu menjalankan model bahasa besar secara privat di servermu sendiri, sehingga kamu punya kendali penuh atas data dan percakapanmu. Dan akan membahas cara setting Ollama dan Open WebUI di VPS dengan cara praktis. Setelah itu, kamu bisa pakai dashboard Open WebUI untuk mengelola model, menyesuaikan output, dan mengenali fitur-fiturnya.

Prasyarat

- VPS Ubuntu 24.04 denganm minimal RAM 8GB (disarankan 16+ untuk model besar)

- Minimal CPU 4 cores

- 50+ GB storage (karena ukuran model bisa 4-70GB per model)

- Akses sudo atau root ke server

Install Ollama dan Open WebUI di VPS

STEP 1: Update Sistem

Buat koneksi ke VPS via SSH lalu update paket sistem:

sudo apt update && sudo apt upgrade -y

sudo apt install curl wget git -y

STEP 2: Install Docker dan Docker Compose

Install docker dengan skrip resminya.

curl -fsSL https://get.docker.com -o get-docker.sh

sudo sh get-docker.sh

Lalu, tambahkan user ke grup docker.

sudo usermod -aG docker $USER

Setelah itu aktifkan service docker.

sudo systemctl start docker

sudo systemctl enable docker

Logout dan login lagi ke SSH supaya perubahan grup berlaku, kemudian periksa instalasi.

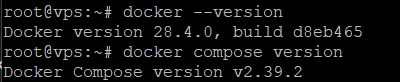

docker --version

docker compose version

STEP 3: Buat Direktori Projek

mkdir ~/ollama-webui

cd ~/ollama-webui

STEP 4: Buat File docker-compose.yml

Buat file docker-compose.yml menggunakan perintah nano dan isi filenya dengan skrip di bawah ini.

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- "11434:11434"

volumes:

- ollama_data:/root/.ollama

environment:

- OLLAMA_HOST=0.0.0.0:11434

restart: unless-stopped

deploy:

resources:

reservations:

memory: 2G

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

- WEBUI_SECRET_KEY=your-secret-key-here

volumes:

- open_webui_data:/app/backend/data

depends_on:

- ollama

restart: unless-stopped

volumes:

ollama_data:

open_webui_data:

Catatan: Ganti your-secret-key-here dengan kunci acak yang bisa dibuat dengan menjalankan perintah:

openssl rand -base64 32

STEP 5: Deploy Layanan

Jalankan semua service dengan docker compose.

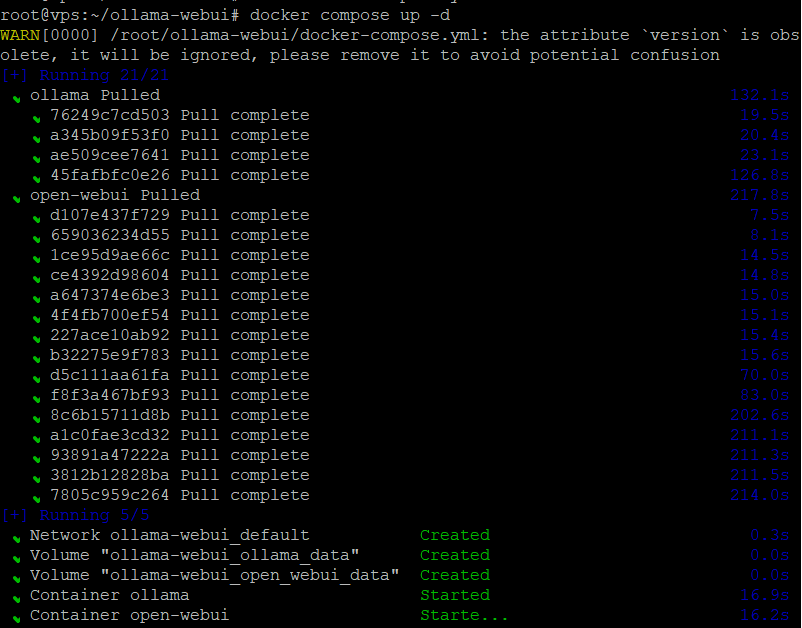

docker compose up -d

Selanjutnya, cek apakah container berhasil berjalan.

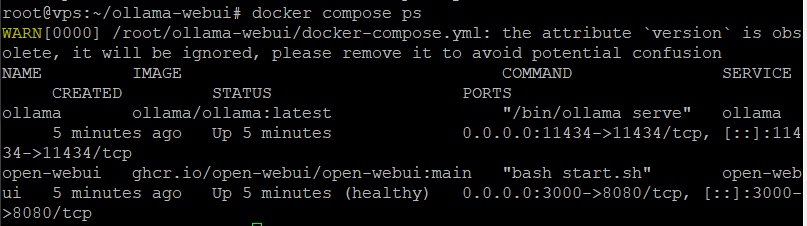

docker compose ps

Untuk memastikan semuanya normal, jalankan perintah di bawah ini untuk melihat log.

docker compose logs -f

STEP 6: Download dan Konfigurasi Model

Pertama, masuk ke container Ollama untuk download model.

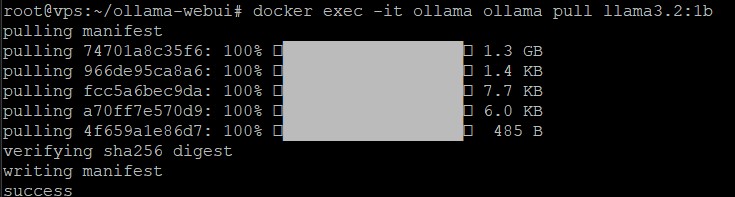

docker exec -it ollama ollama pull llama3.2:1b

Untuk model yang lebih besar, mungkin kamu bisa menginstal:

docker exec -it ollama ollama pull llama3.2:8b

docker exec -it ollama ollama pull codellama:7b

Model code Llama yang disukai karena kemampuannya untuk coding dan hal-hal terkait pemrograman. Sedangkan, Llama 3.2 dioptimalkan untuk pemahaman bahasa yang lebih luas dan tugas-tugas penalaran, sehingga sangat cocok untuk percakapan alami, rangkuman, dan pertanyaan pengetahuan umum.

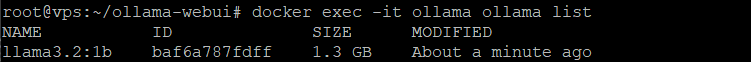

Untuk melihat daftar model terinstal gunakan perintah berikut ini.

docker exec -it ollama ollama list

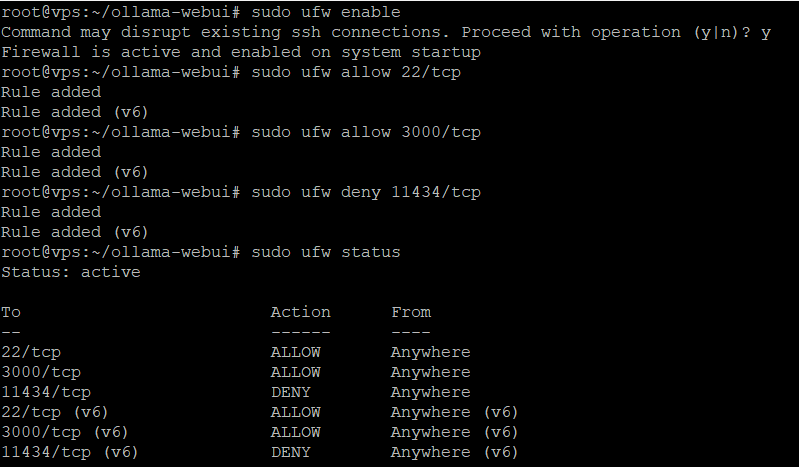

STEP 7: Konfigruasi Firewall dan Keamanan

Gunakan UFW untuk mengamankan server.

sudo ufw enable

sudo ufw allow 22/tcp

sudo ufw allow 3000/tcp

sudo ufw deny 11434/tcp

sudo ufw status

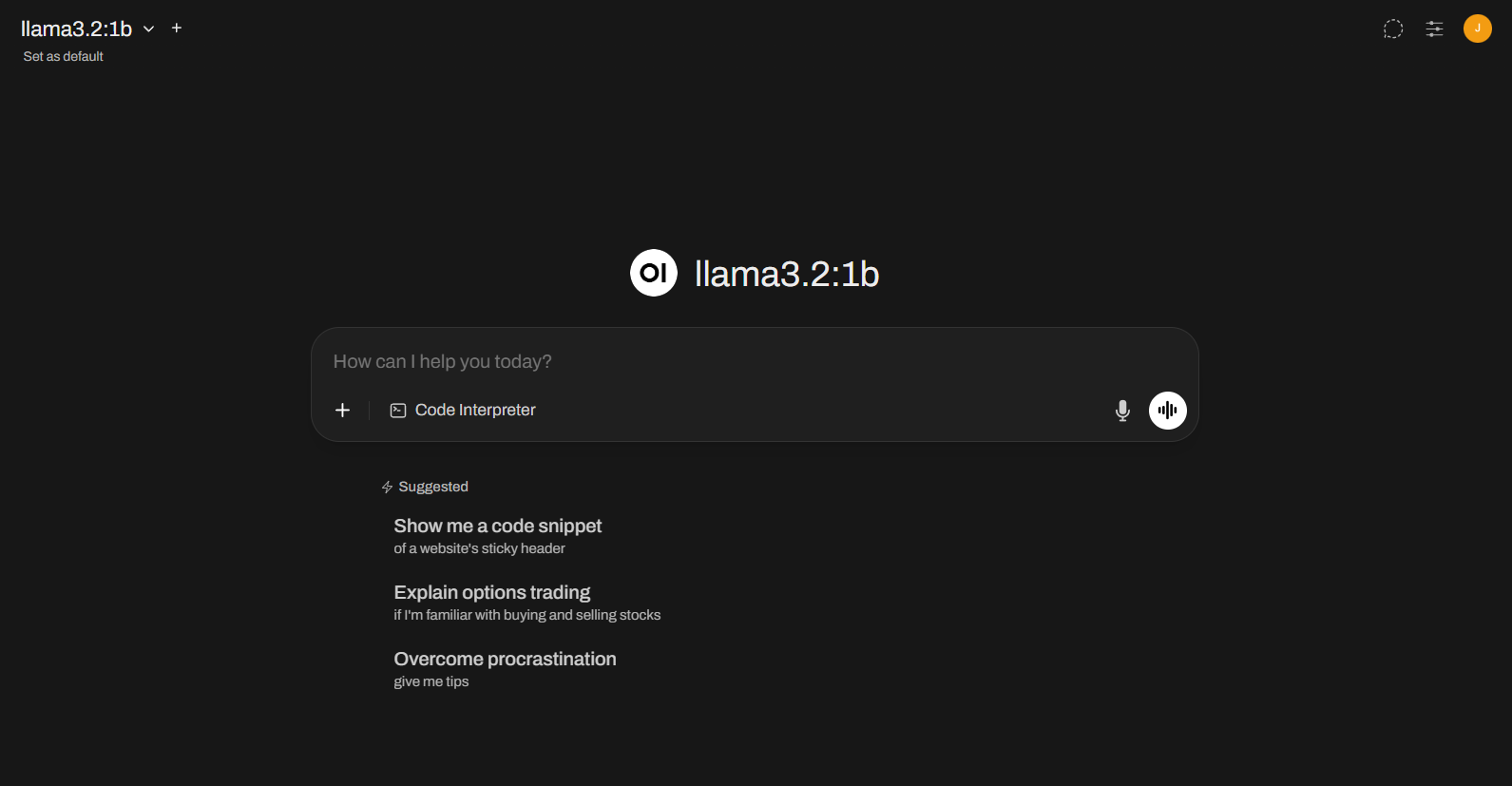

STEP 8: Akses Open WebUI

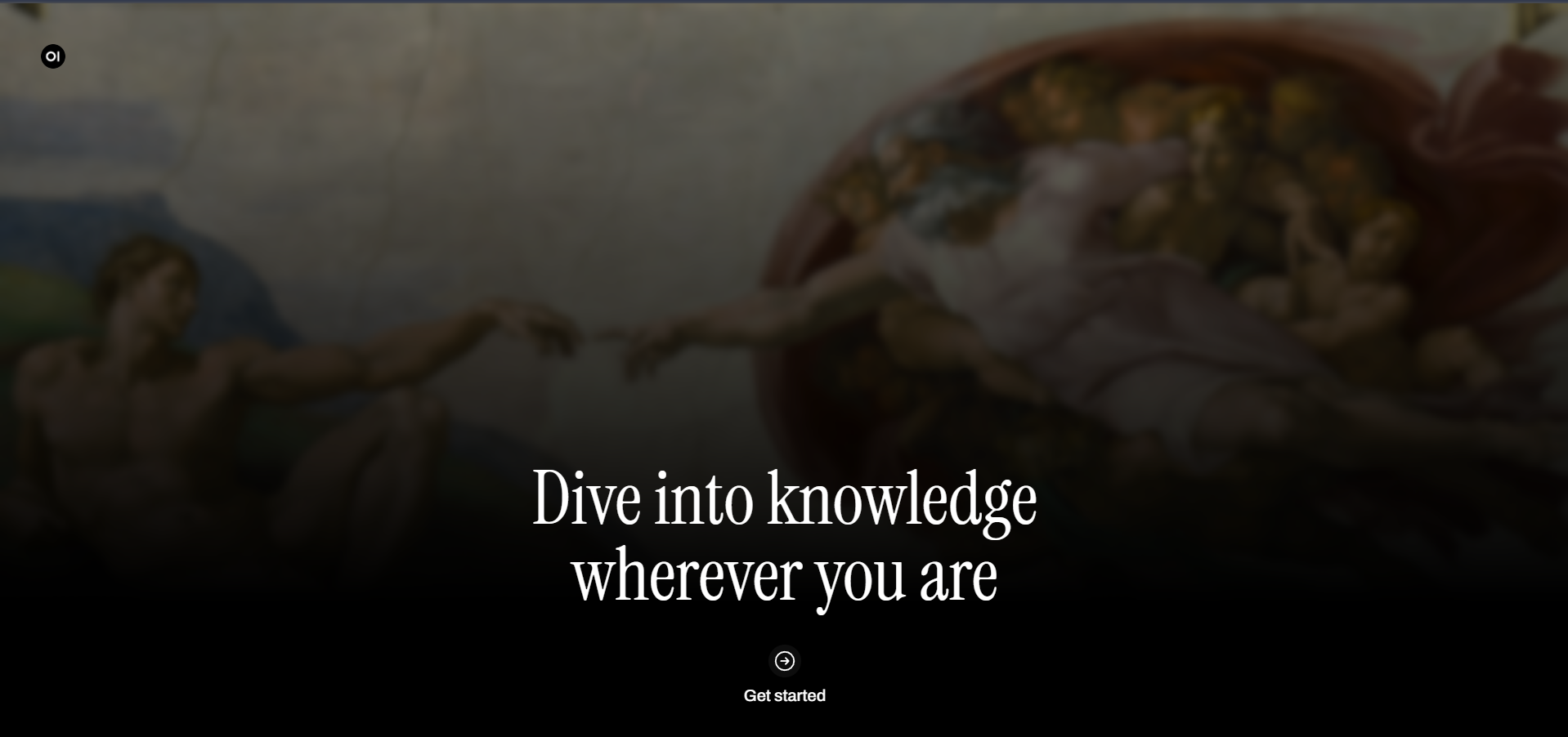

Buka browser dan akses http://ip-server:3000/ kemudian klik Get started.

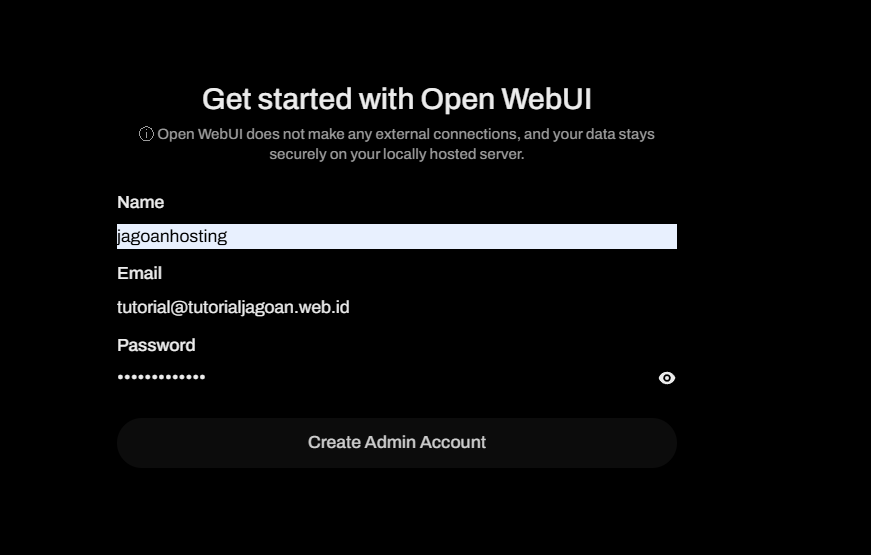

Saat pertama kali, kamu akan diminta membuat akun admin.

Setelah login, kamu bisa, memulai percakapan dengan model yang sudah diunduh, download model lain dari antarmuka web, dan lain sebagainya. Setelah bagian ini, penjelasan dilanjutkan dengan mengenal interface dan fitur pada Open WebUI serta memberi infromasi kepada kamu bagaimana melakukan interaksi dasar.

Mengenal Dashboard Open WebUI

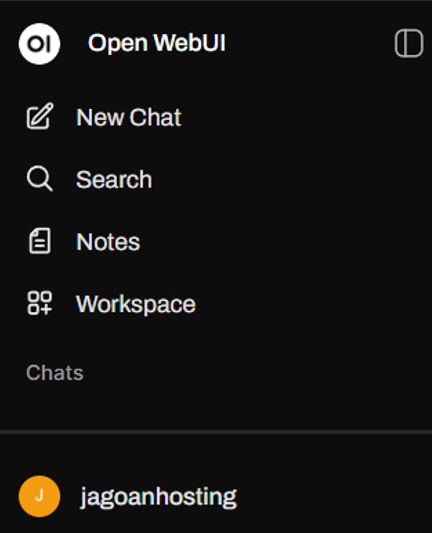

Dashboard di Open WebUI tampilannya intuitif. Kalau kamu pernah coba ChatGPT, pasti langsung familiar. Tampilannya dibagi jadi dua bagian:

- Panel utama (data panel): tempat kamu mengobrol dengan model pakai prompt teks, upload file, atau bahkan perintah suara. Dari sini kamu juga bisa ganti model atau unduh model baru.

- Sidebar kiri: tempat kamu mengatur percakapan, membuat chat baru, melanjutkan chat lama, menyimpan, atau menghapus obrolan. Di sini juga ada menu workspace untuk bikin model custom.

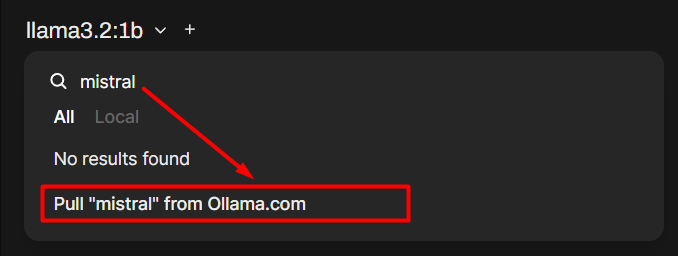

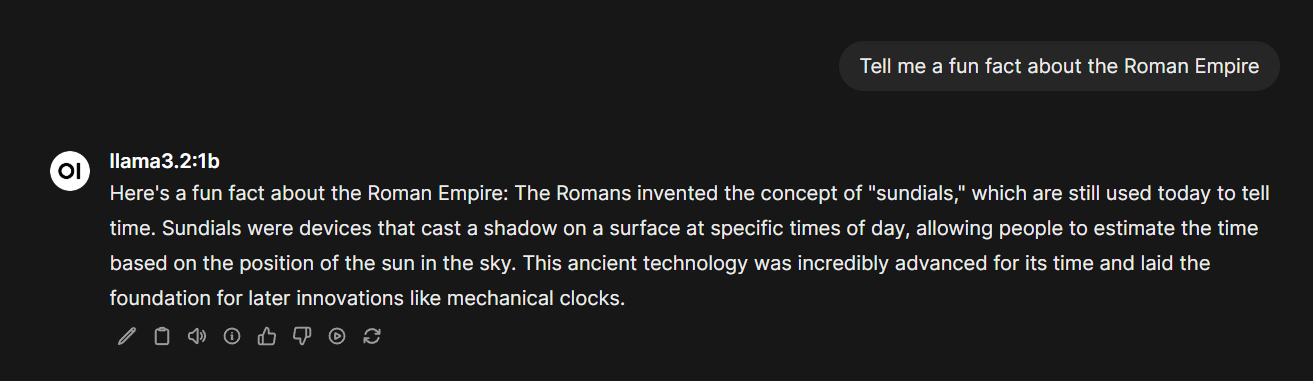

Memilih dan Jalankan Model

Setelah Ollama + Open WebUI terpasang, biasanya model bawaan seperti Llama 3.1 sudah siap dipakai. Tapi kamu bisa download model lain dari library Ollama langsung dari panel pemilihan model.

Contohnya:

- Mistral: terkenal cepat untuk ringkas teks & terjemahan.

- Code Llama: cocok buat coding dan soal pemrograman.

Setelah model didownload, klik New Chat, pilih model, lalu ketik prompt kamu. Hasilnya bisa kamu salin, beri feedback, atau generate ulang kalau kurang pas.

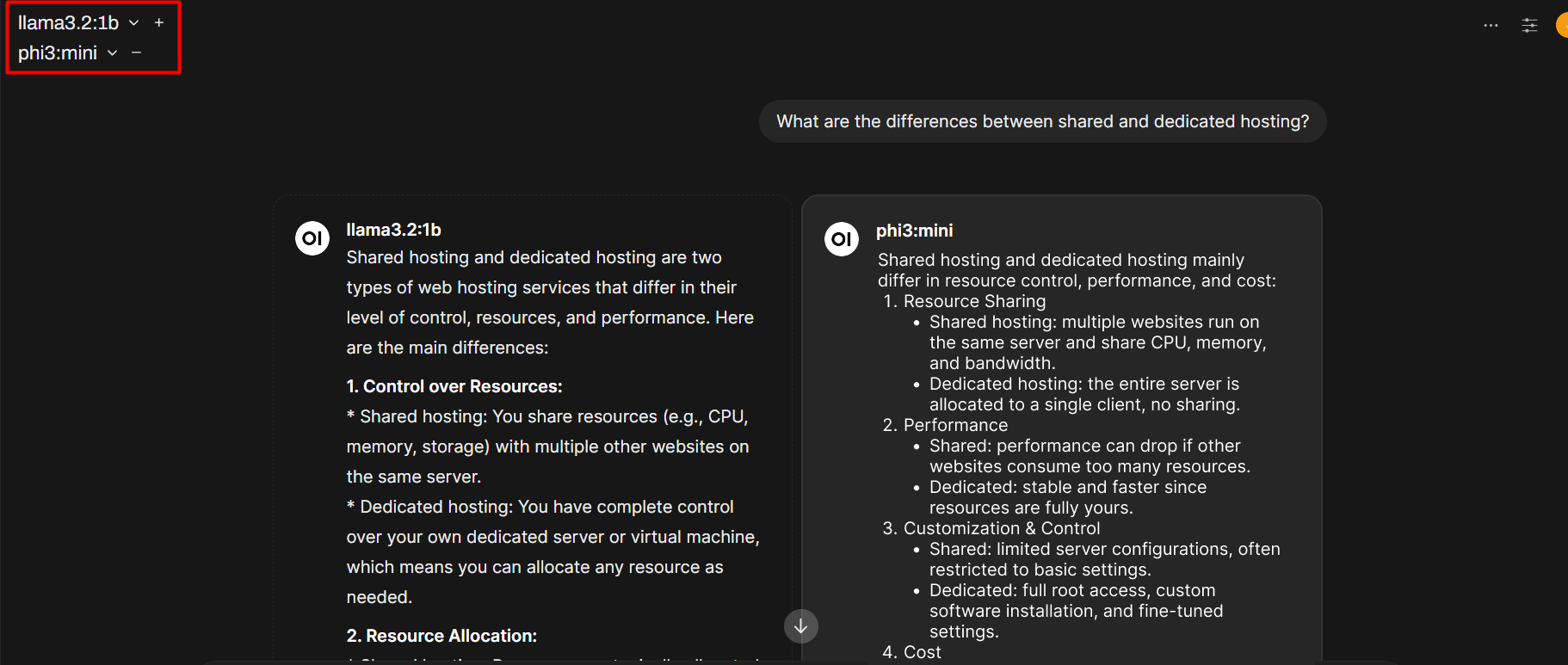

Kerennya, kamu bisa ganti model di tengah percakapan. Misalnya mulai pakai Llama untuk diskusi umum, lalu lanjut dengan Vicuna buat jawaban lebih spesifik. Bahkan bisa jalankan beberapa model bareng untuk dibandingkan hasilnya secara berdampingan.

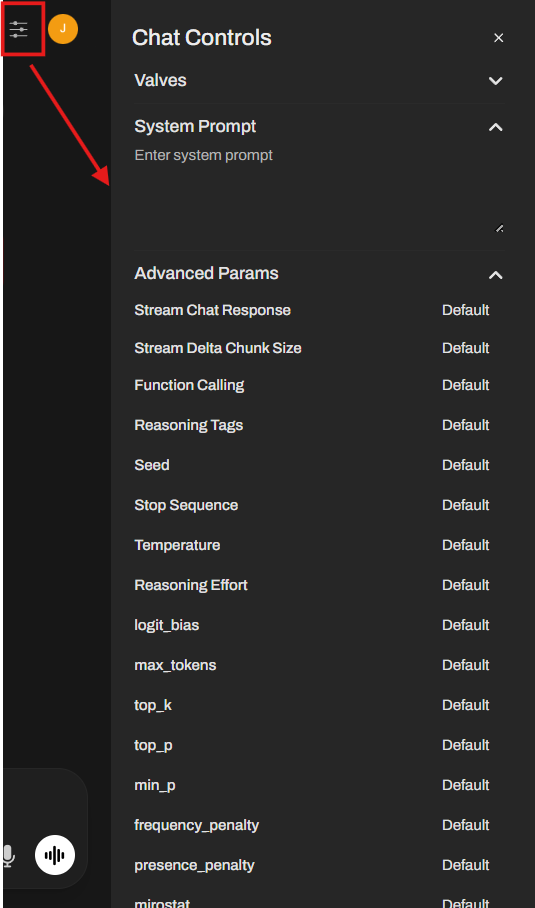

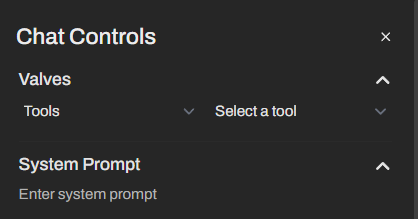

Menyesuaikan Output Model

Open WebUI juga membari kontrol penuh ke kamu untuk mengatur cara model menjawab. Di menu Chat Control, kamu bisa atur:

Stream Chat Response – Menampilkan jawaban secara real-time, langsung muncul saat diproses tanpa menunggu selesai.

- Seed: menjamin hasil yang konsisten dengan output sama untuk prompt yang sama, cocok untuk pengujian.

- Stop Sequence: menentukan kata/frasa sebagai tanda berhenti agar respons berakhir alami.

- Temperature: mengatur tingkat kreativitas: rendah = fokus & dapat diprediksi, tinggi = lebih variatif.

- Mirostat: menjaga alur respons tetap relevan dan lebih panjang, terutama untuk prompt detail.

- Frequency Penalty: mengurangi pengulangan kata agar pilihan kata lebih bervariasi.

- Context Length: menetapkan banyaknya informasi yang diingat model untuk menjaga kelancaran percakapan.

- Max Tokens (num_predict): membatasi panjang respons supaya tetap singkat

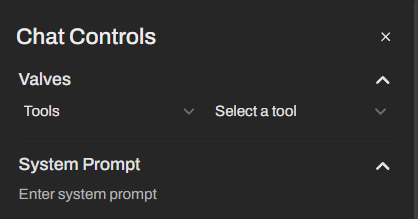

Di menu yang sama, kamu dapat mengatur Valves untuk memilih berbagai tool atau fungsi tambahan yang bisa dipanggil model, serta System Prompt untuk menentukan peran, gaya bahasa, dan perilaku model dalam percakapan.

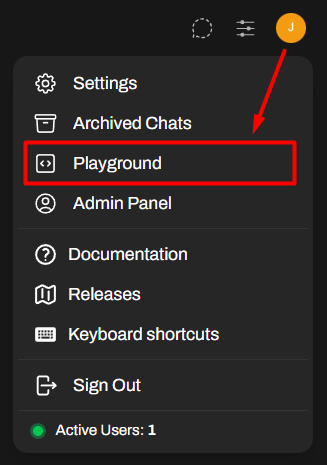

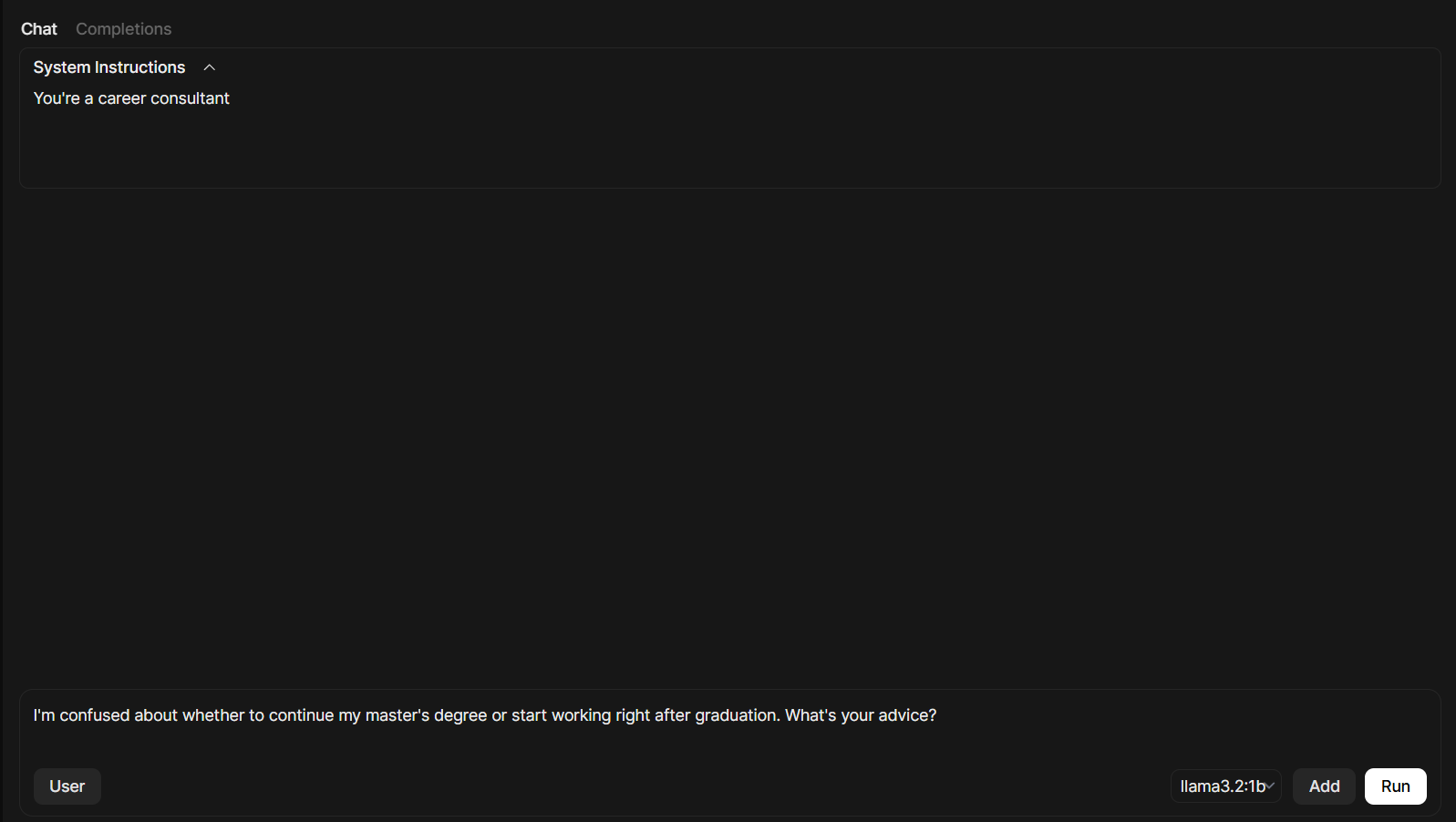

Di sudut kanan atas terdapat mode Playground yang bisa digunakan untuk mencoba berbagai pengaturan dan jenis prompt.

Pada tab Chat, kamu dapat menguji alur percakapan, misalnya:

- System Instructions: menentukan peran atau instruksi khusus bagi model.

- User Message: mengirim pertanyaan atau perintah langsung ke model.

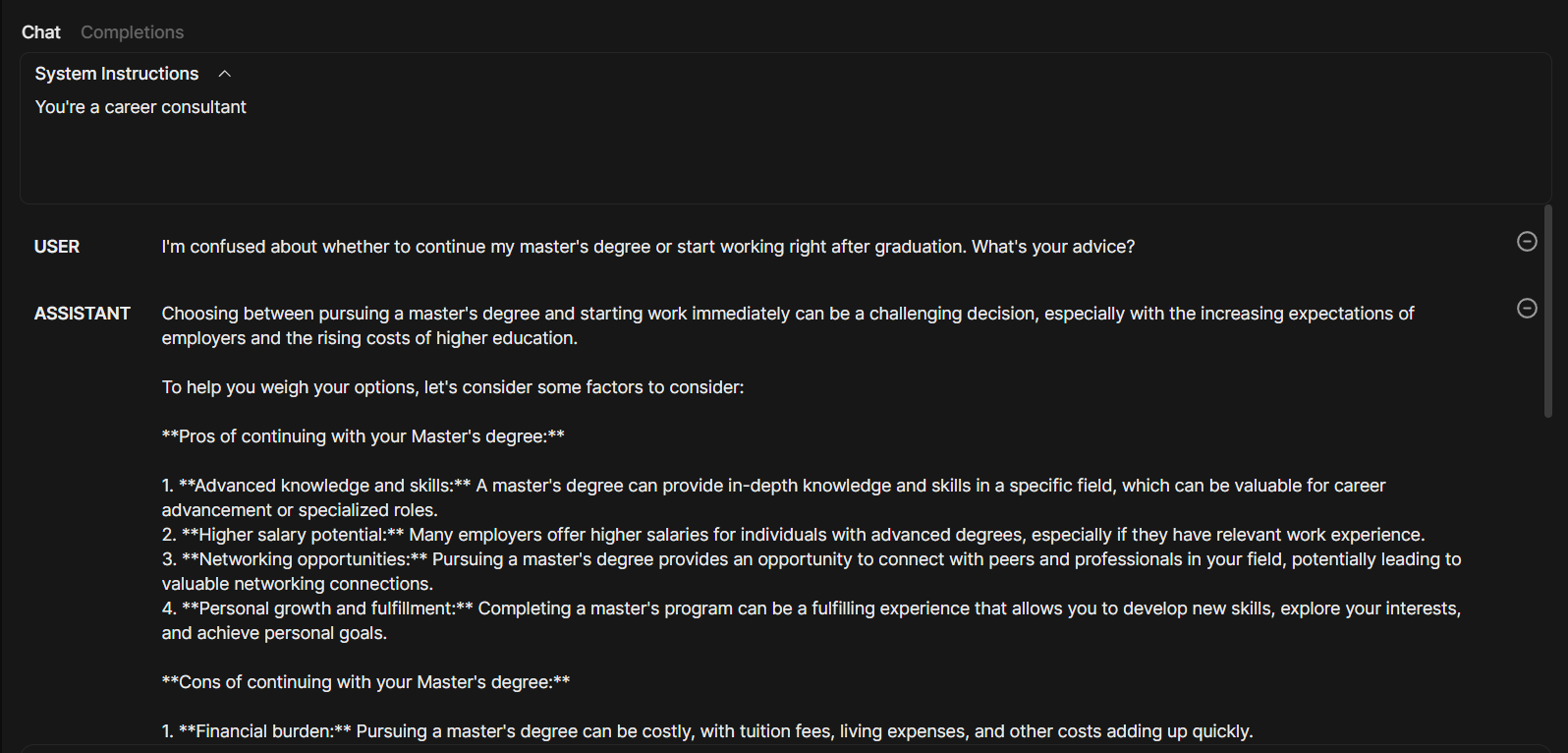

Contoh: jika instruksi sistem diisi “kamu adalah konsultan karir”, maka setiap pertanyaan yang dimasukkan pengguna akan dijawab sesuai sudut pandang tersebut.

Output yang diberikan kurang lebih seperti ini.

Di sisi lain, tab Completion digunakan untuk meminta model membuat respons dengan melanjutkan teks yang kamu tulis. Contohnya, jika menulis “Machine learning is…”, model akan meneruskan kalimat tersebut untuk memberikan penjelasan mengenai machine learning.

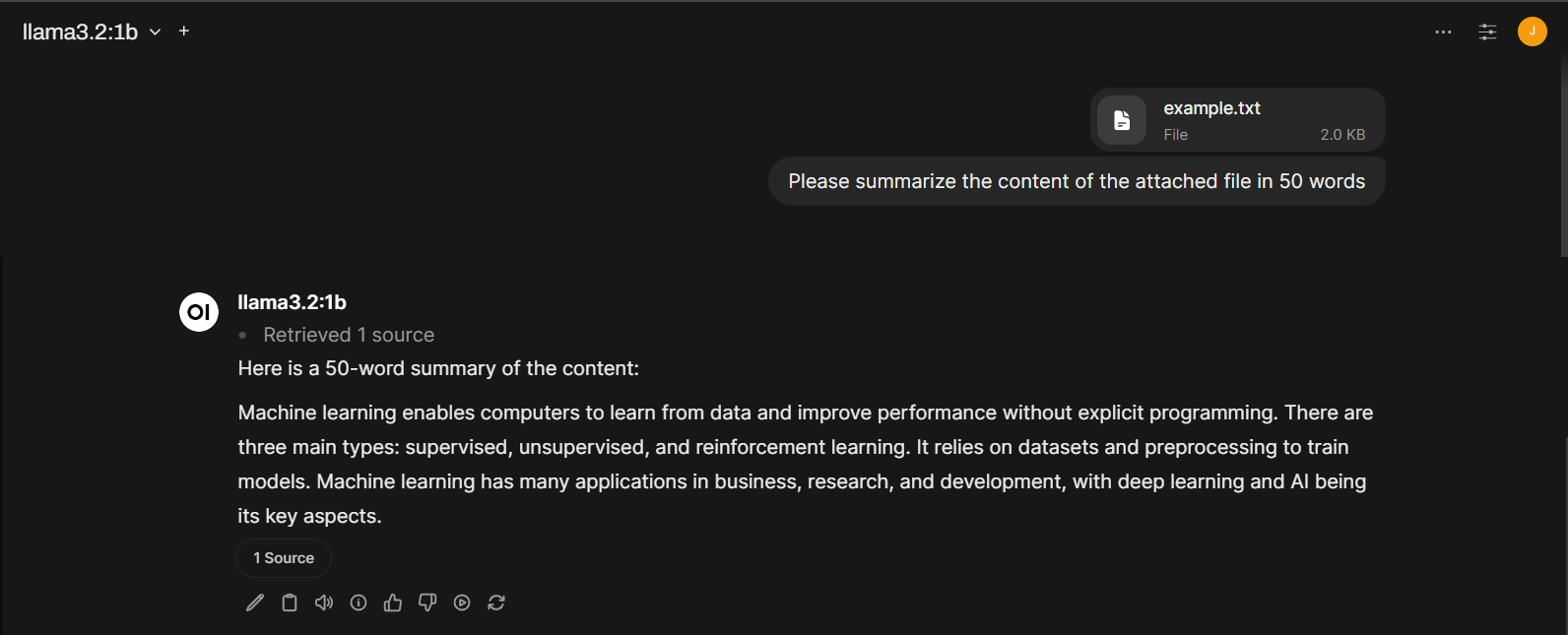

Mengakses Dokumen dan Halaman Web

Ollama bersama Open WebUI sudah mendukung fitur RAG (retrieval-augmented generation). Fitur ini bikin respons model AI jadi lebih relevan karena model bisa menarik informasi terbaru langsung dari sumber eksternal, seperti dokumen yang kamu upload atau halaman web. Dengan begitu, kamu nggak cuma dapat jawaban standar, tapi juga hasil yang sesuai konteks dan up-to-date.

Di Open WebUI, kamu bisa langsung upload dokumen dalam format DOC, PDF, TXT, atau RTF. Caranya: klik tombol “+” di kolom prompt, pilih Upload File, lalu masukkan instruksi.

Contoh: Please summarize the content of the attached file in 50 words (Tolong rangkum isi file terlampir dalam 50 kata.)

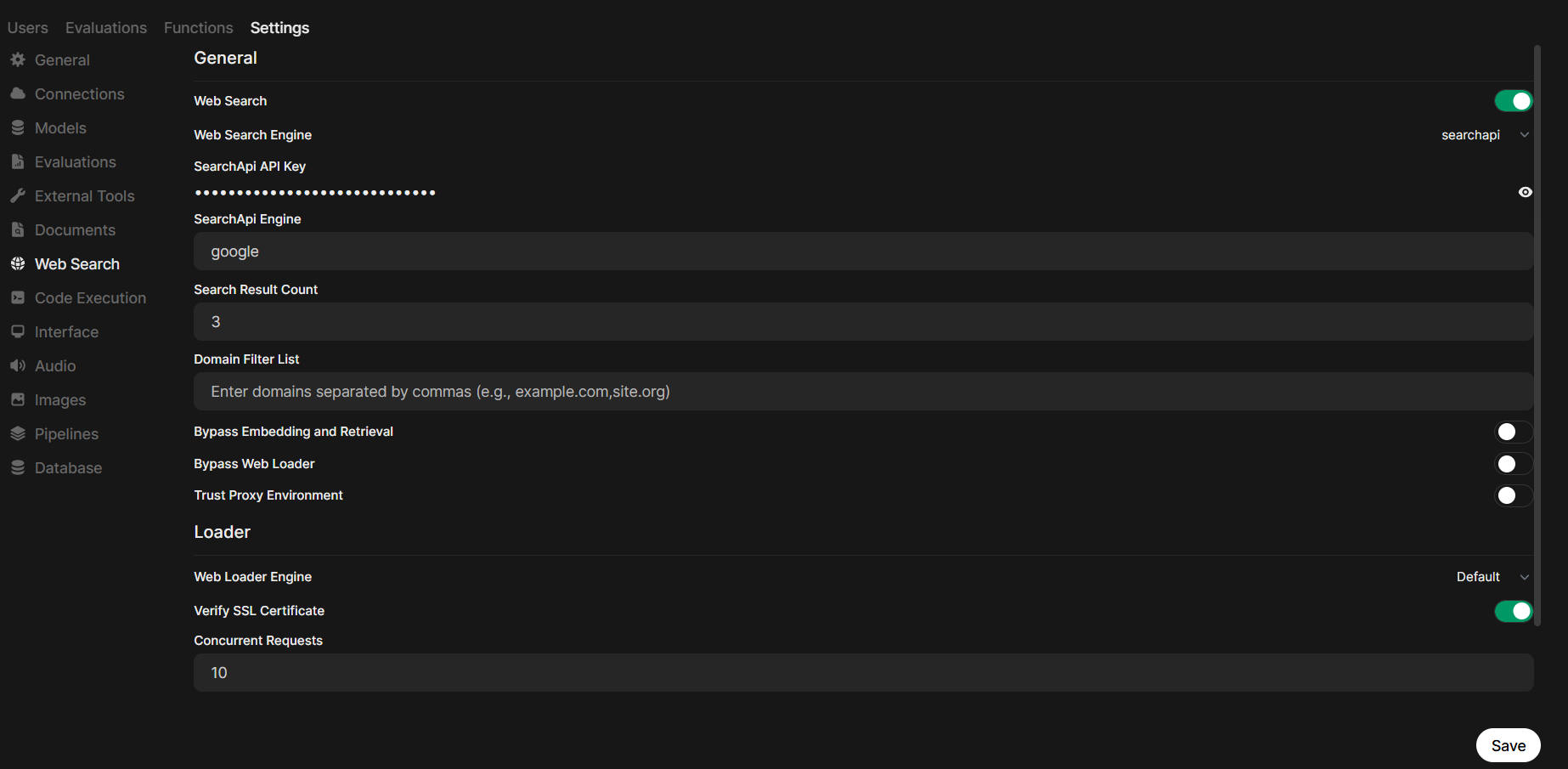

Kalau kamu butuh model menelusuri informasi di internet, aktifkan integrasi SearchAPI. SearchAPI ini berfungsi sebagai jembatan agar model bisa mencari data real-time dari web. Langkahnya:

- Buka website resmi SearchAPI lalu buat akun.

- Salin API Key dari dashboard.

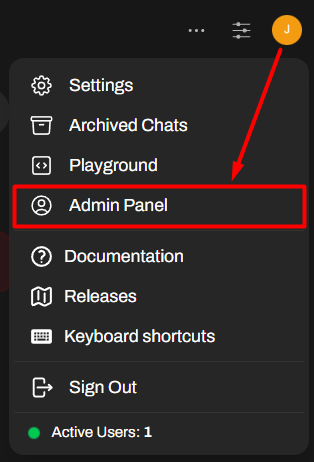

- Di Open WebUI, masuk ke Profil > Admin Panel.

- Masuk ke Settings (Pengaturan) > pilih tab Web Search (Pencarian Web) dan aktifkan fitur Web Search.

- Di pilihan mesin pencari, kamu bisa pakai Google, Bing, atau Baidu (default-nya Google).

- Tempelkan API Key tadi di SearchAPI API Key, lalu Save (Simpan).

Setelah setup selesai, cukup klik tombol “+” di kolom pesan dan aktifkan Web Search. Sekarang kamu bisa minta model untuk langsung mengambil informasi dari internet.

Bekerja Sama dalam Tim

Kalau kamu pakai Open WebUI untuk kerja tim, ada fitur manajemen pengguna yang bisa sangat membantu. Kamu bisa menambahkan akun baru dengan role berbeda (user atau admin).

Caranya: buka Admin Panel > klik ikon + untuk tambah pengguna, lalu masukkan nama, email, password, dan pilih rolenya.

Bagikan kredensial ini ke anggota timmu supaya mereka bisa login. Tapi ingat, pengguna dengan role non-admin nggak bisa mengakses workspace atau panel admin.

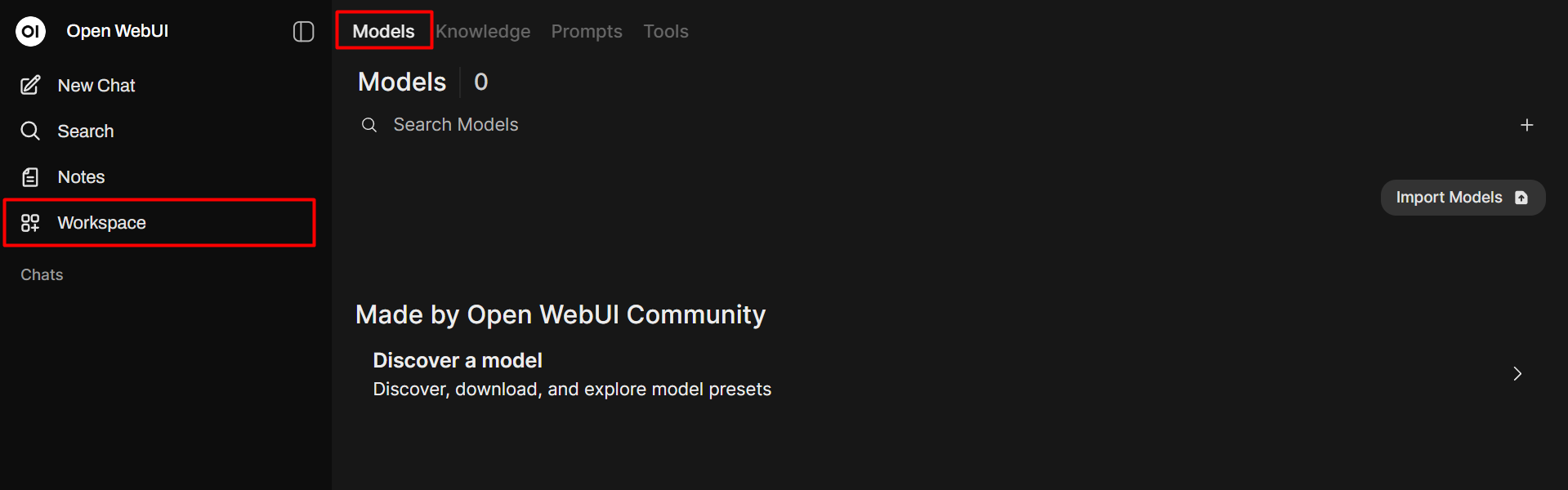

Selanjutnya, cobalah berbagai fitur di area Workspace melalui sidebar sebelah kiri. Di tab Models, kamu dapat membuat model baru dari model yang sudah tersedia, mengimpor model khusus dari komunitas Open WebUI, atau menghapus model yang telah diunduh.

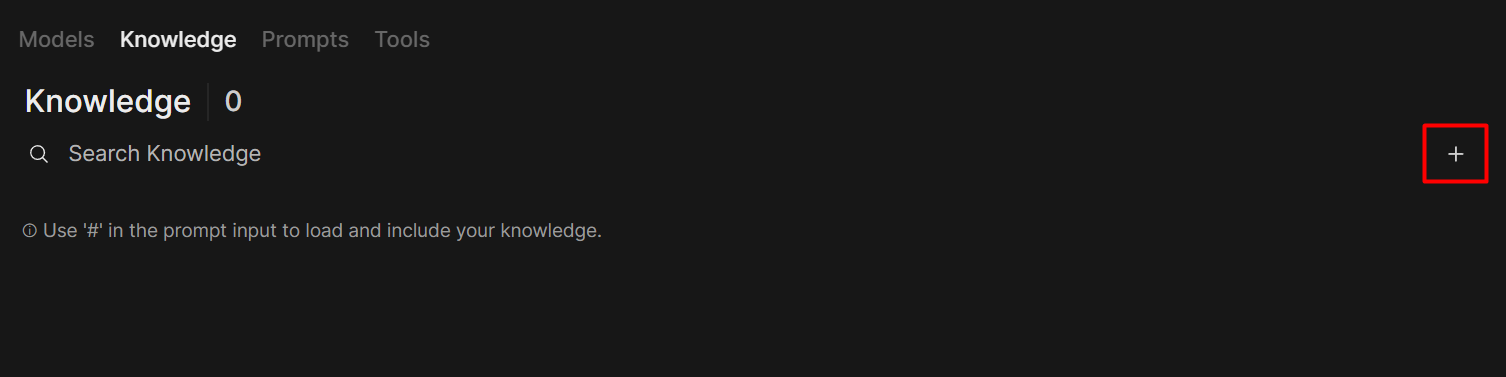

Jika kamu belum menyiapkan resource pengetahuan namun ingin melatih model baru, buka tab Knowledge, klik tombol +, dan ikuti instruksi untuk mengimpor dataset kamu. Setelah mengunggah dataset, kembali ke model yang dibuat dan impor pengetahuan yang baru ditambahkan ke dalamnya.

Kamu dapat melakukan penyesuaian serupa di tab Prompts, Tools, dan Functions. Jika ragu, kamu juga bisa mengimpor preset yang dibuat oleh komunitas pengguna lain.

Menggunakan Model Multimodal

Selain model berbasis teks, Ollama juga mendukung model multimodal, yaitu model yang bisa memproses teks sekaligus gambar. Beberapa model populer yang bisa kamu coba adalah LLaVa, BakLLaVA, dan MiniCPM-V.

Misalnya kamu ingin menggunakan LlaVa. Setelah mendownloadnya dari panel pemilihan model, kamu bisa menggunakannya untuk berbagai tugas.

Contoh penggunaan dengan LLaVa:

- Upload gambar pantai > tanya: “What is in this image?” > model akan menjawab isi gambar.

- Upload foto kucing > tanya: “How many cats are in this image?” > model akan menghitung jumlah kucing di dalam gambar.

Kamu juga bisa minta model untuk bikin deskripsi singkat dari sebuah gambar, semacam auto-caption. Tapi perlu dicatat, LLaVa saat ini belum bisa menghasilkan gambar baru, fokusnya hanya menganalisis dan menjelaskan gambar yang kamu berikan.

Dengan Ollama + Open WebUI, kamu bisa jalankan LLM di VPS kamu sendiri lewat tampilan GUI yang gampang dipahami. Nggak perlu lagi pusing dengan command-line, cukup pakai dashboard interaktif.

Kamu bisa pilih model, sesuaikan jawaban, upload file, integrasi web search, bahkan bikin model custom untuk tim. Jadi lebih fleksibel, aman, dan seru buat eksplorasi AI di server pribadi kamu.

Kalau ada yang masih bikin bingung, jangan ragu hubungi Tim Support Jagoan Hosting melalui Live Chat atau Open Ticket, Sob. Good luck, ya!

Pengantar Halo sobat Jagoan! di tutorial kali ini kita bakalan membahas permasalahan Error Undefined Index/Variable. Pasti sekarang kamu lagi main-main Read more

Hai, Sobat Jagoan! Apa sobat sudah tau apa itu FTP Session Control? nih, Sob FTP Session Control bisa dibilang alat Read more

Hai Sob! Apakah Sobat sedang mencari cara gimana caranya melakukan backup data website melalui softacolous pada cPanel? Tenang aja Sob, Read more

Hai Sob! Apakah Sobat butuh panduan untuk melakukan setting Mail pada Mac OS Sobat? Tenang aja Sob! Jagoan Hosting selalu Read more