Hai, Sobat Jagoan! Ollama adalah pilihan tepat kalau kamu ingin menjalankan Large Language Model (LLM) secara lokal dengan aman. Dengan begitu, privasi data kamu lebih terjaga, dan kamu bisa menghemat biaya karena nggak perlu menggunakan cloud. Tool ini sangat cocok untuk industri yang harus menjaga kerahasiaan data, misalnya layanan kesehatan atau keuangan, dan bisa disesuaikan dengan kebutuhan spesifik kamu.

Artikel kali ini akan membahas cara menginstal Ollama di VPS dengan langkah-langkah mudah. Cara ini cocok buat kamu yang ingin menggunakan Ollama lewat CLI. Sebelum memulai, kenali dan pahami dulu informasi tentang Ollama berikut.

Apa itu Ollama?

Ollama adalah platform open-source yang memungkinkan kamu menjalankan LLM kustom langsung di komputer atau server lokal kamu. Platform ini mendukung berbagai model populer seperti Llama 2, GPT-3.5, dan Mistral.

Dengan Ollama, kamu bisa mengintegrasikan AI secara lokal ke aplikasi kamu. Hal ini meningkatkan keamanan dan privasi data, sekaligus memberi kamu kontrol lebih besar atas performa model. Misalnya, kamu bisa mengatur bobot model, konfigurasi, dan dataset melalui antarmuka yang mudah dipakai. Ollama juga memungkinkan kamu menyesuaikan model bahasa sesuai kebutuhan spesifik, yang sangat berguna bagi developer atau peneliti AI yang suka bereksperimen.

Kalau kamu ingin menggunakan Ollama untuk aplikasi web tanpa bergantung pada API pihak ketiga, kamu perlu menyiapkannya di server hosting kamu terlebih dahulu.

Cara Kerja Ollama

Ollama bekerja dengan menjalankan model bahasa besar secara lokal di sistem kamu. Intinya, model ini seperti “otak AI” yang bisa memproses teks, memahami konteks, dan menghasilkan respons.

Saat kamu mengirim prompt atau pertanyaan ke Ollama, mesin lokal akan memproses input itu menggunakan model yang sudah diinstal. Model membaca bobot dan parameter yang tersimpan secara lokal, lalu menghasilkan jawaban berdasarkan data dan algoritma yang dipelajarinya. Semua proses ini langsung di komputer atau VPS kamu, jadi data kamu tidak perlu dikirim ke cloud. Kamu bisa menyesuaikan model dengan dataset khusus, mengubah konfigurasi performa, atau mengatur kapasitas memori dan GPU agar model berjalan optimal sesuai kebutuhan.

Berikut ini langkah-langkah menginstal Ollama di VPS. Simak sampai akhir, ya.

Step 1: Update dan Upgrade Sistem

Sebelum mulai instalasi, update list package dan perbarui package lama ke versi terbaru dulu.

sudo apt update && sudo apt upgrade -y

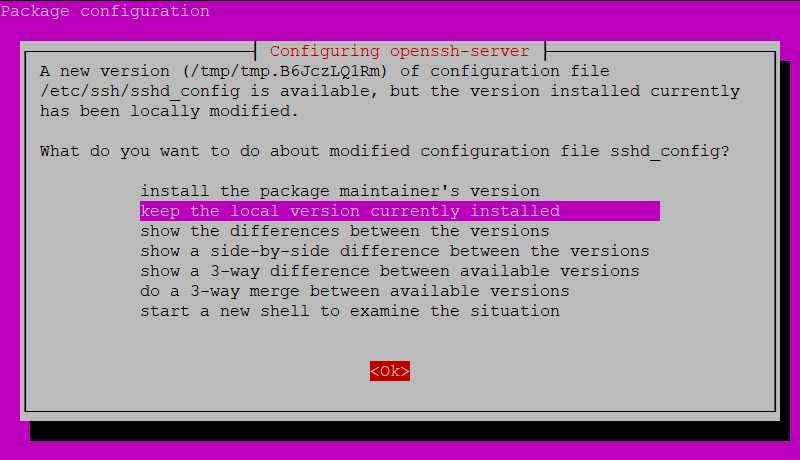

Ketika muncul package configuration seperti berikut, klik Tab untuk memilih tombol OK lalu Enter.

Step 2: Unduh Dependensi Untuk Instalasi Ollama

Agar Ollama bisa berjalan dengan lancar, instal dependensi yang diperlukan seperti python, pip, dan git menggunakan perintah:

sudo apt install python3 python3-pip git

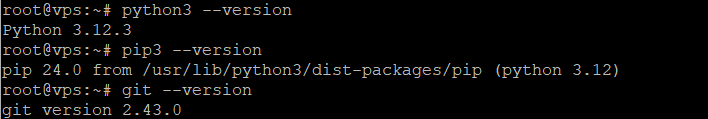

Setelah selesai menginstal, jalankan perintah di bawah ini untuk memastikan instalasi dependensi berhasil.

python3 --version

pip3 --version

git --version

Step 3: Install Ollama di VPS

Selanjutnya, instal Ollama dengan langkah-langkah berikut:

Jika VPS kamu menggunakan GPU NVIDIA, tambahannya kamu butuh instal driver CUDA agar memaksimalkan performa Ollama. Namun, langkah-langkahnya akan berbeda-beda tergantung konfigurasi server. Untuk mengunduh CUDA toolkit pelajari di situs resminya NVIDIA.

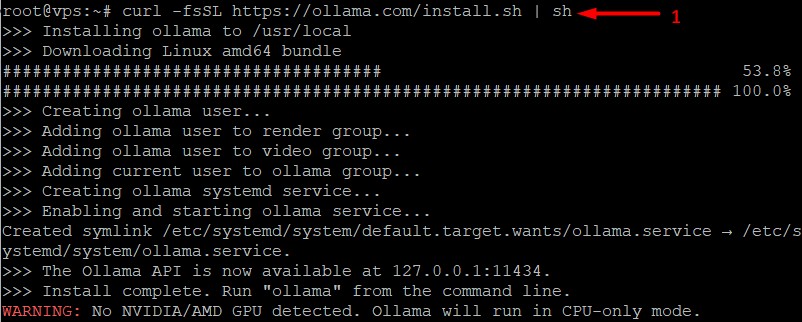

Instal Ollama menggunakan perintah di bawah ini.

curl -fsSL https://ollama.com/install.sh | sh

Dan buat kamu yang ingin tetap install Ollama tanpa GPU, perintah yang dijalankan sama seperti di atas. Tetapi, mungkin output instalasinya akan menampilkan warning yang memberi tahu kalau kamu tidak pakai GPU, Ollama fallback pakai CPU.

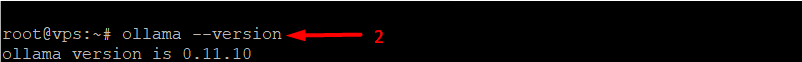

Untuk memastikan Ollama telah diunduh di VPS, jalankan perintah yang akan menunjukkan versi Ollama yang terpasang.

ollama --version

Step 4: Menjalankan Ollama

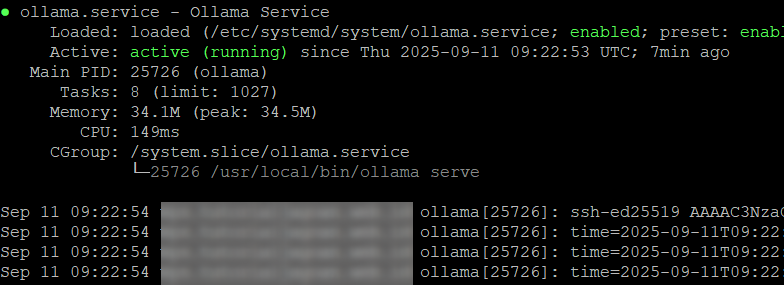

Setelah berhasil memasang Ollama, biasanya ia akan langsung aktif di server. Untuk melihat status layanan Ollama telah berjalan, gunakan perintah berikut:

systemctl status ollama

Jika belum aktif, jalankan dengan perintah:

ollama serve

Step 5: Konfigurasi Ollama

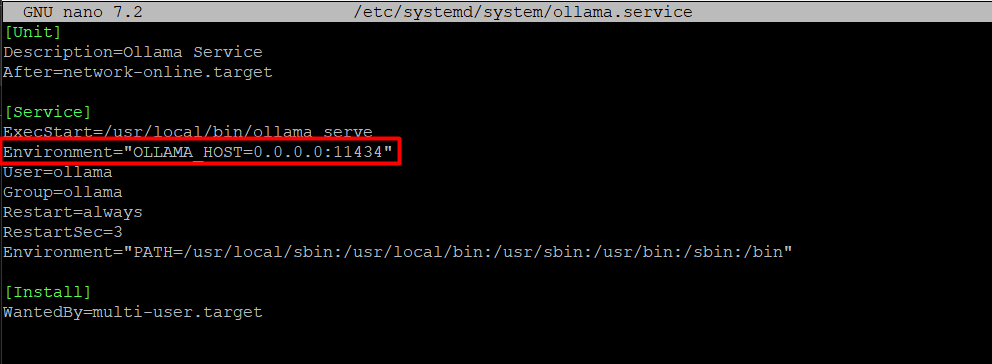

Buat file layanan systemd agar Ollama berjalan secara otomatis di IP publik setiap kali kamu memuat (boot) VPS.

Catatan: Secara default Ollama memiliki konfigurasi systemd untuk penggunaan di dalam VPS yang berjalan di 127.0.0.1:11434. Pengaturan konfigurasi di bawah ini mengatur agar Ollama dapat diakses oleh public IP, jadi apabila kamu tidak ingin terhubung ke publik tetap gunakan konfigurasi defaultnya saja.

sudo nano /etc/systemd/system/ollama.service

Tambahkan skrip di bawah ini ke file systemd Ollama.

Environment="OLLAMA_HOST=0.0.0.0:11434"

Simpan perubahan dengan Ctrl+X, Y lalu Enter. Dan muat ulang sistem.

systemctl daemon-reload

systemctl restart ollama

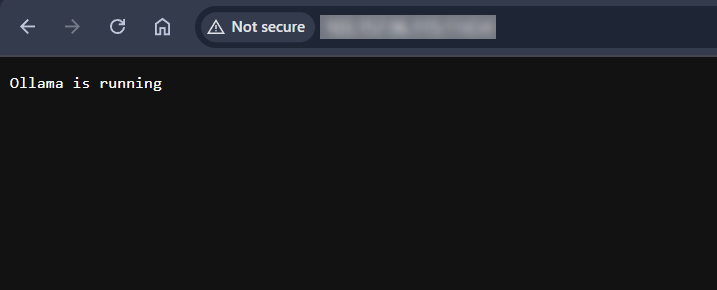

Setelah restart Ollama, akses service API Ollama melalui http://ip-server:11434/ di browser. Pastikan menampilkan informasi “Ollama is running”. Jika membuka akses publik, jangan lupa mengatur firewall agar hanya IP tertentu yang bisa mengakses, atau tambahkan autentikasi/reverse proxy untuk keamanan tambahan.

Selesai! Kamu sudah berhasil menginstal Ollama di VPS Ubuntu 24.04 dan mengkonfigurasinya agar berjalan otomatis pada saat memulai VPS. Supaya akses Ollama dengan IP public lebih aman, jangan lupa untuk menambahkan proteksi agar lebih aman.

Apabila ingin menggunakan Ollama melalui tampilan antarmuka (bukan melalui CLI), ikuti cara instal dan konfigurasinya di artikel Cara Setting dan Menggunakan Ollama dengan Open WebUI

Kalau ada yang masih bikin bingung, jangan ragu hubungi Tim Support Jagoan Hosting melalui Live Chat atau Open Ticket, Sob!

Pengantar Halo sobat Jagoan! di tutorial kali ini kita bakalan membahas permasalahan Error Undefined Index/Variable. Pasti sekarang kamu lagi main-main Read more

Hai Sob! Apakah Sobat butuh panduan untuk melakukan setting Mail pada Mac OS Sobat? Tenang aja Sob! Jagoan Hosting selalu Read more

Hai Sob! Apa Sobat lagi bingung gimana caranya mempercepat load website dengan caching browser? Santai aja Sob, dibawah ini banyak Read more

Pernahkah kamu mengalami error yang berkaitan dengan phpinfo mysqli, gd, pdo, zip, mcrypt, mbstring? Nggak perlu panik, Sob, kamu hanya Read more